數據處理 從原始信息到價值洞察的基石

數據無處不在,它記錄了企業的運營軌跡、用戶的互動行為、世界的萬千變化。原始數據往往是雜亂、不完整甚至充滿噪聲的。數據處理,正是將這些原始的、未經雕琢的“原材料”,轉化為清晰、可靠、可用的“成品信息”的關鍵過程。它是連接數據采集與數據分析、數據應用的橋梁,是現代數字化決策的基石。

數據處理是一個系統性的流程,通常包含幾個核心階段。首先是數據采集與輸入,從各種源頭(如數據庫、傳感器、日志文件、API接口)收集原始數據。緊隨其后的是至關重要的數據清洗與預處理階段。在這一步,數據工程師和分析師需要識別并處理缺失值、異常值、重復記錄,糾正不一致的格式(例如,將日期統一為“YYYY-MM-DD”格式),并解決數據中的錯誤。這個過程雖然耗時,但直接決定了后續分析結果的質量,正所謂“垃圾進,垃圾出”。

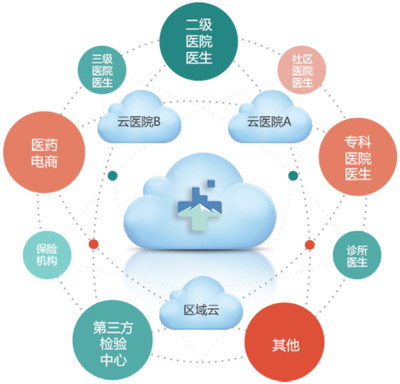

清洗后的數據將進入數據轉換與集成階段。這里可能涉及數據格式的轉換(如將文本數據轉換為數值型)、數據的規范化或標準化(使不同量綱的數據具有可比性),以及將來自多個不同來源的數據合并成一個統一、一致的視圖。例如,將客戶關系管理系統中的客戶信息與電商平臺的交易記錄進行關聯整合。

接下來是數據存儲與管理。處理后的數據需要被有效地存儲起來,以便快速檢索和使用。根據數據量、查詢速度和業務需求,可以選擇關系型數據庫(如MySQL)、NoSQL數據庫(如MongoDB)、數據倉庫(如Snowflake)或數據湖等不同的存儲方案。良好的數據管理還包括建立清晰的數據目錄、元數據管理和數據安全策略。

經過處理的數據被輸出與交付給最終用戶或下游系統。這可能以報表、可視化儀表板、API接口或直接輸入到機器學習模型中的形式呈現。高效的數據處理流程能夠確保決策者、業務分析師和數據科學家獲得及時、準確的信息,從而驅動智能決策、優化運營和發現新的商業機會。

在當今大數據和人工智能時代,數據處理的技術也在飛速演進。自動化數據流水線(如使用Apache Airflow調度)、實時流處理(如Apache Kafka, Flink)和云原生數據處理服務,大大提升了處理的效率和規模。其核心目標始終未變:將數據轉化為可信、可用的資產,為組織挖掘深層價值提供堅實可靠的基礎。重視并投資于穩健、高效的數據處理能力,已成為所有數據驅動型組織的核心競爭力。

如若轉載,請注明出處:http://www.xbyszz.cn/product/55.html

更新時間:2026-02-14 22:33:35